Multi-group convolutional neural network for gender recognition of Portunus tritubereulatus

-

摘要:

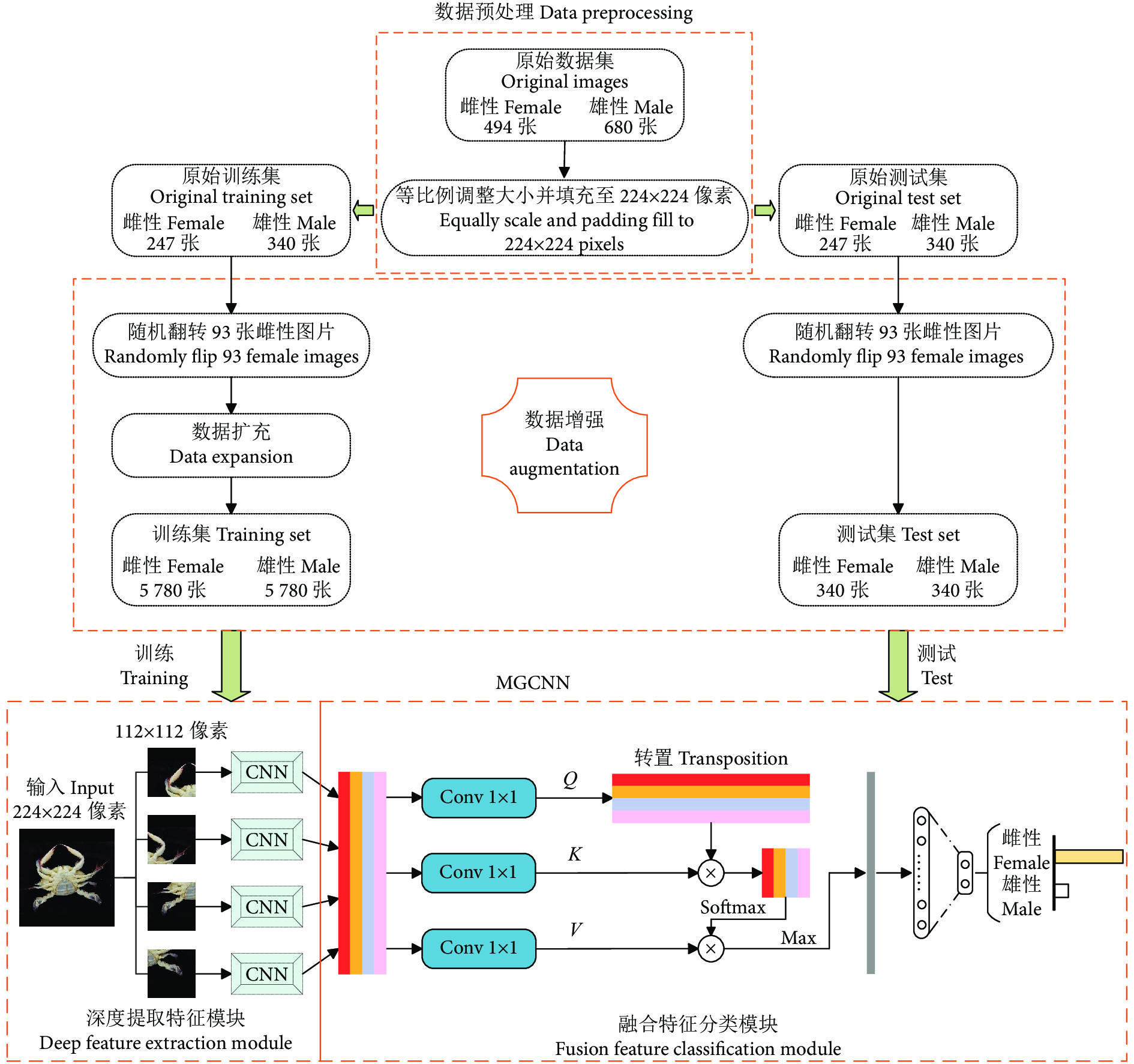

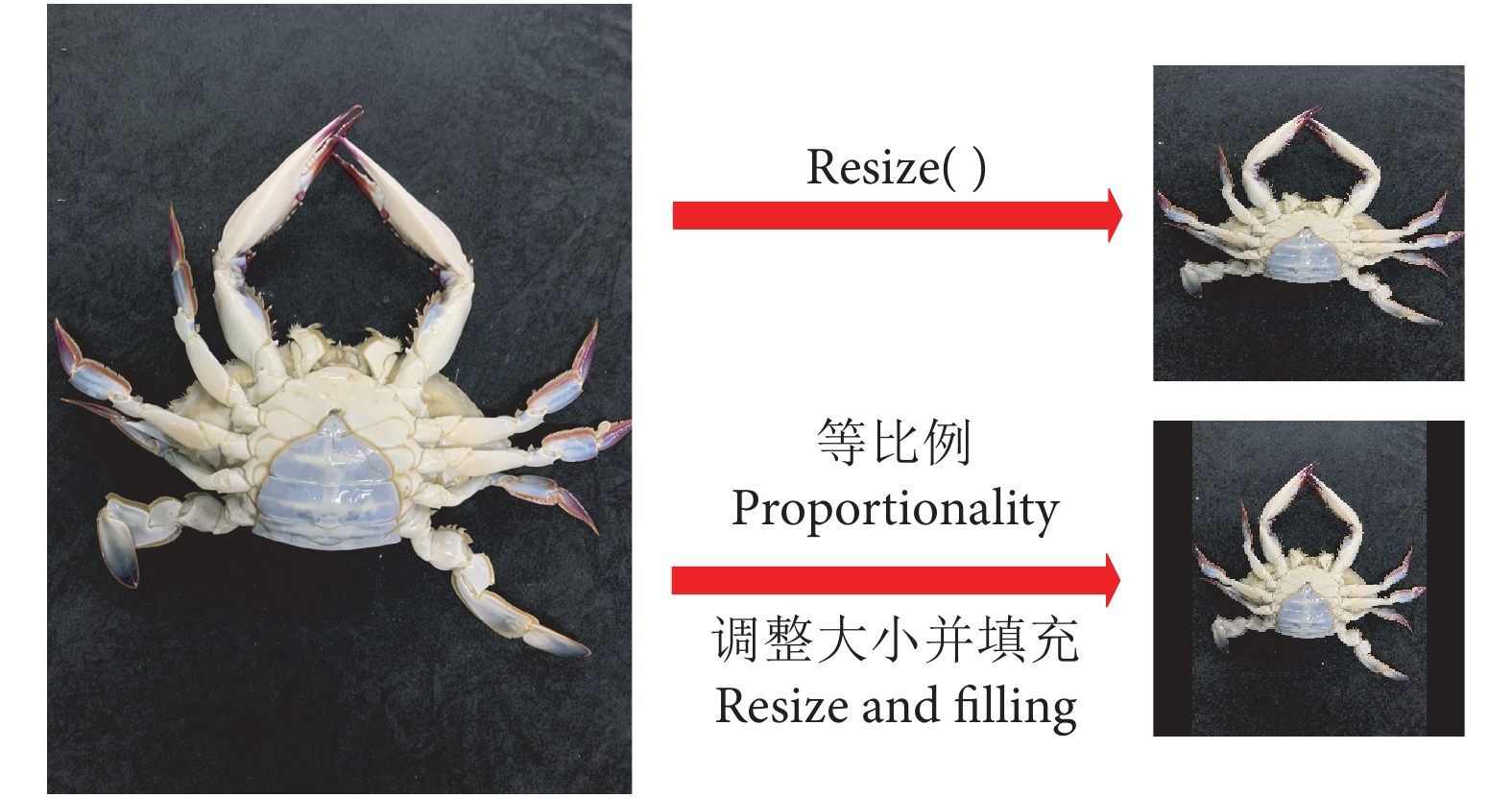

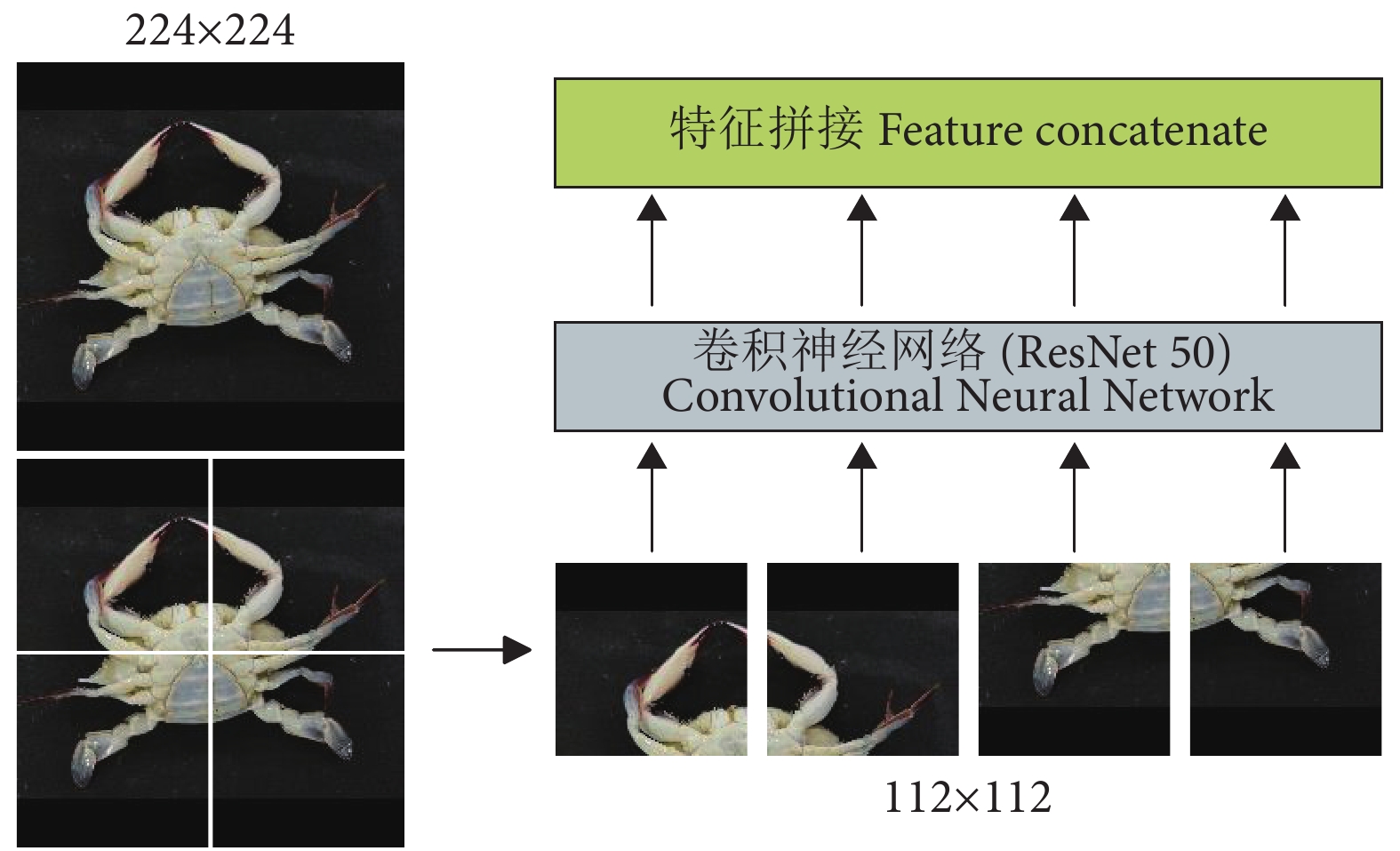

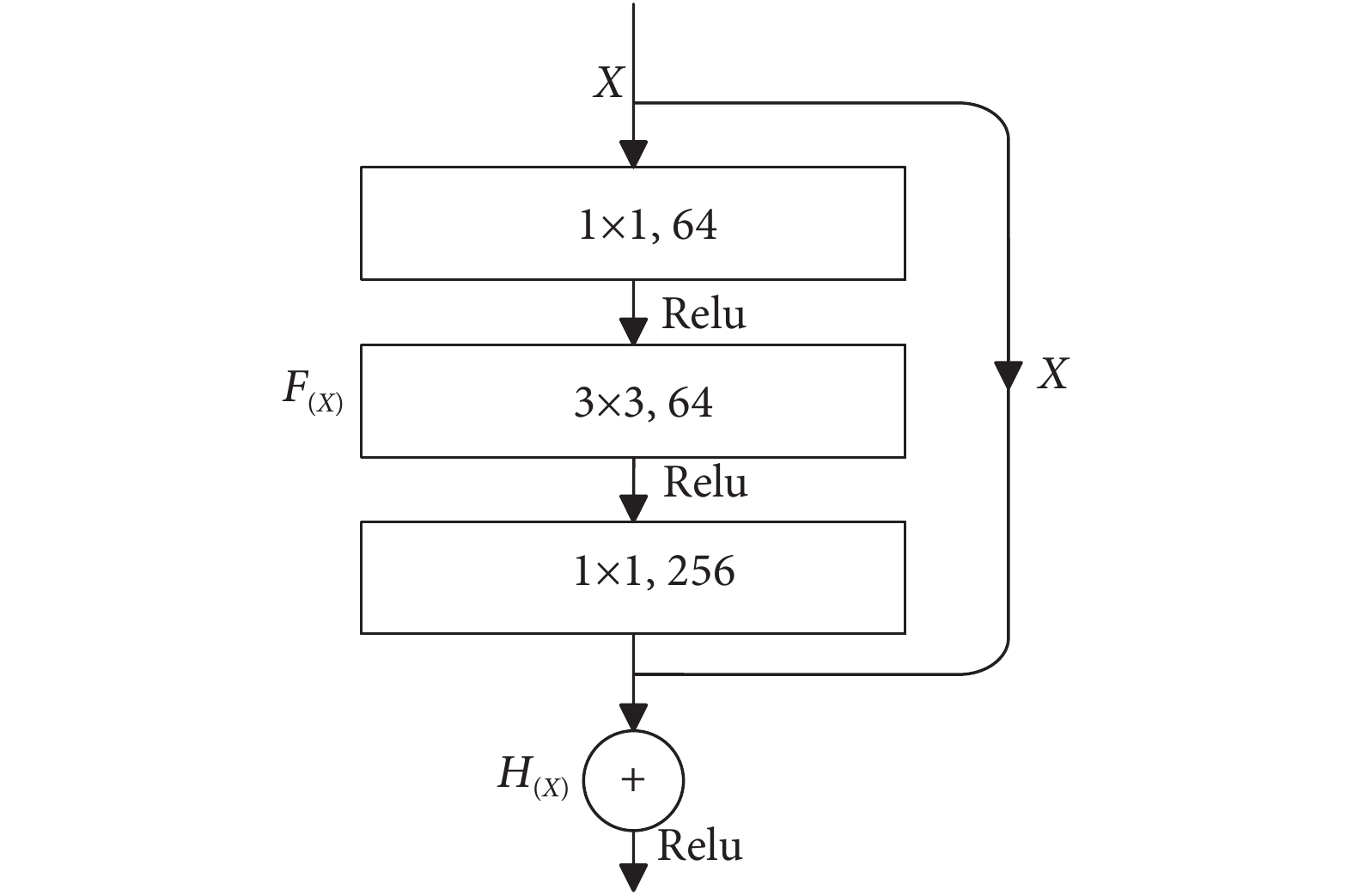

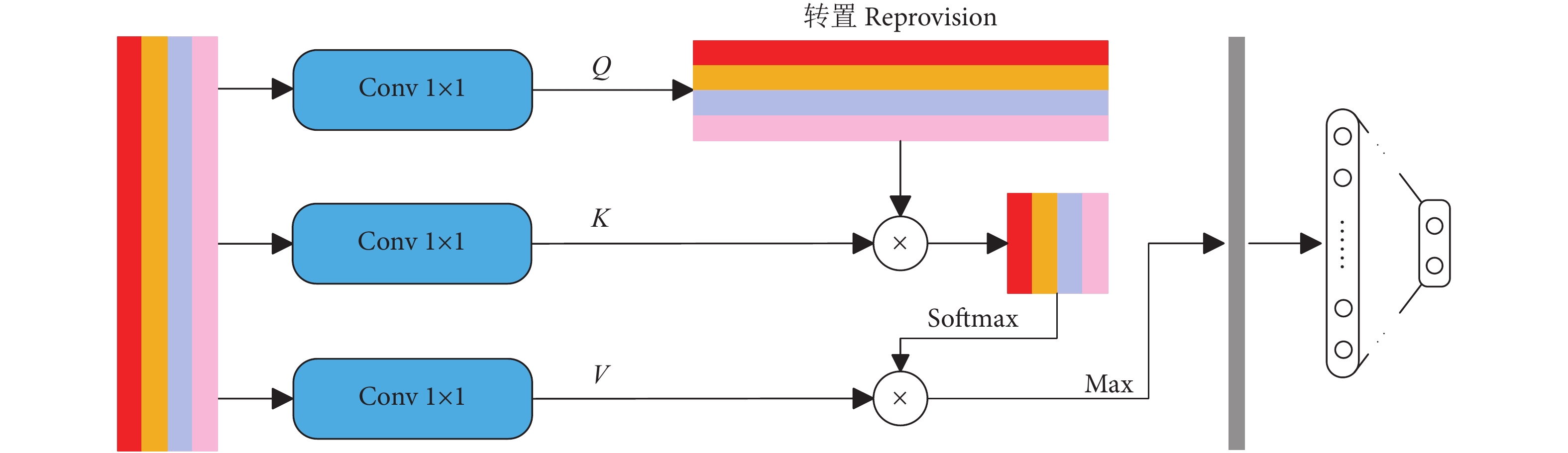

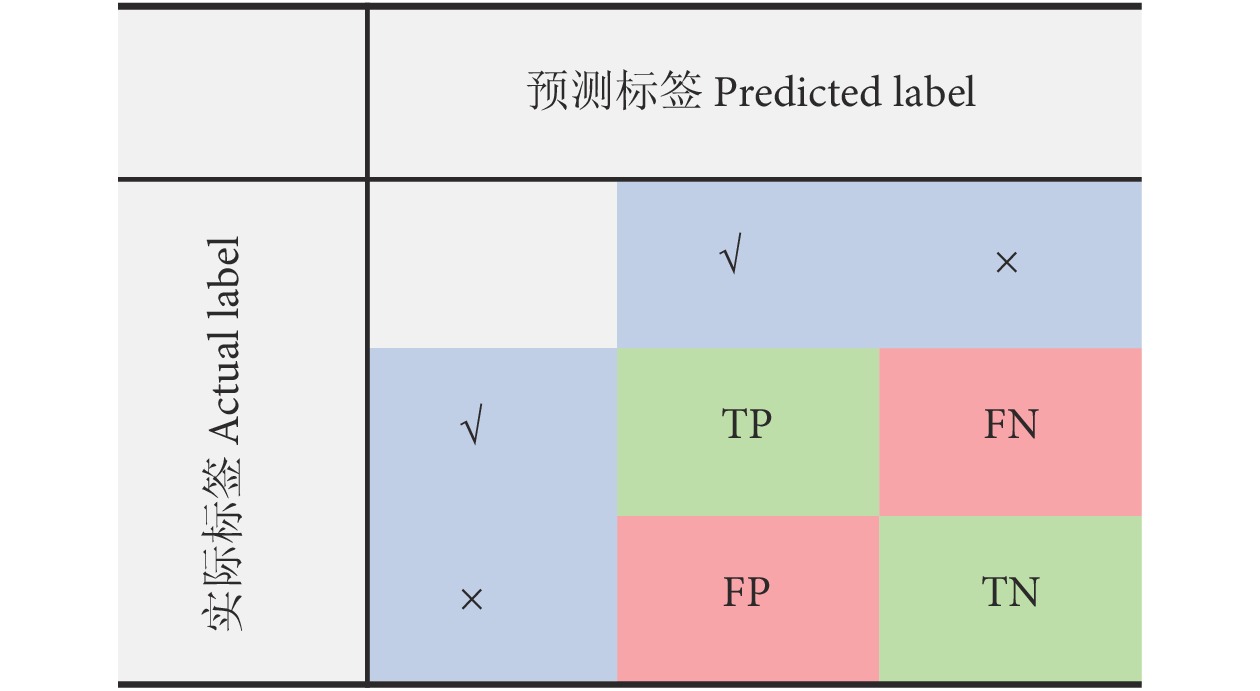

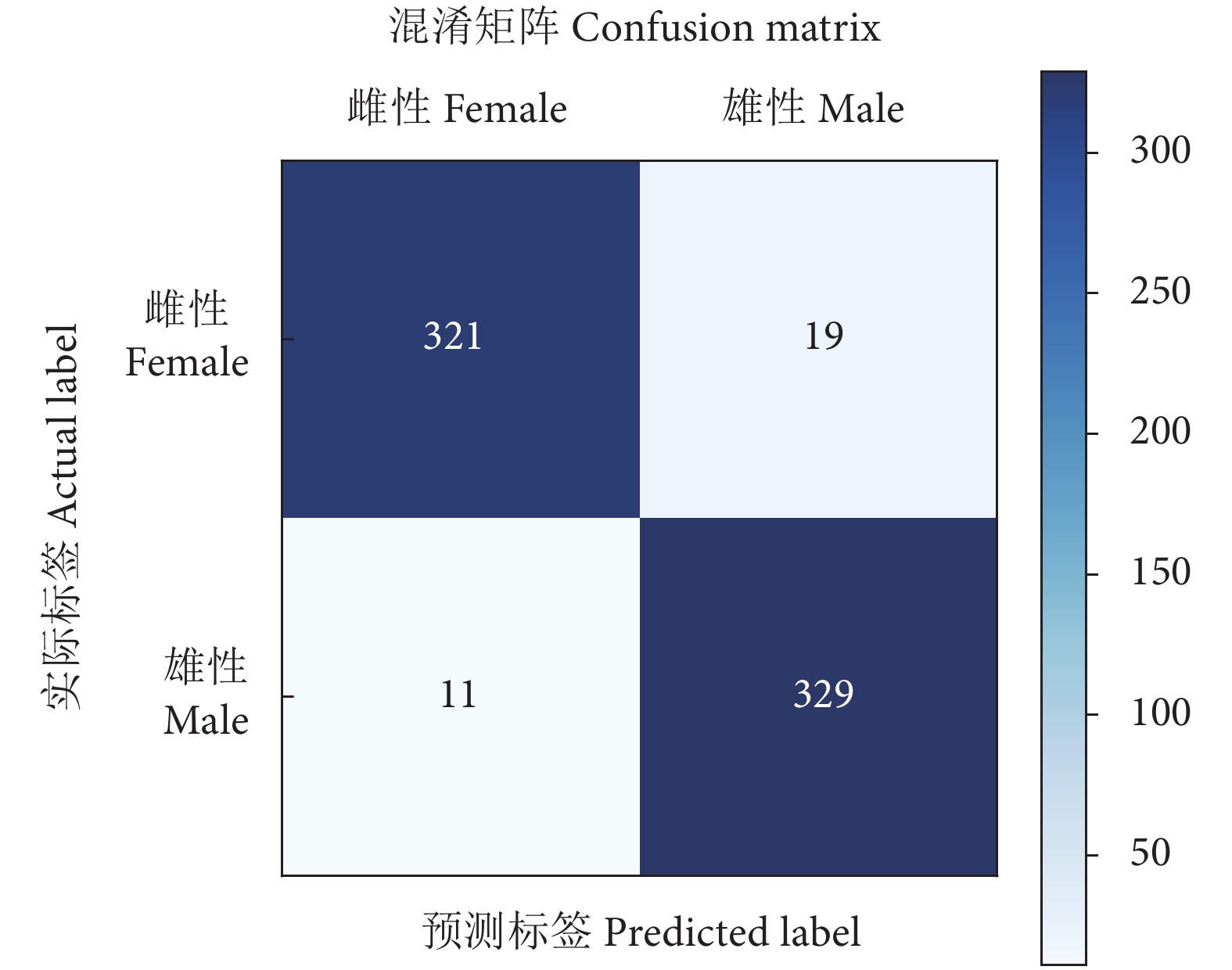

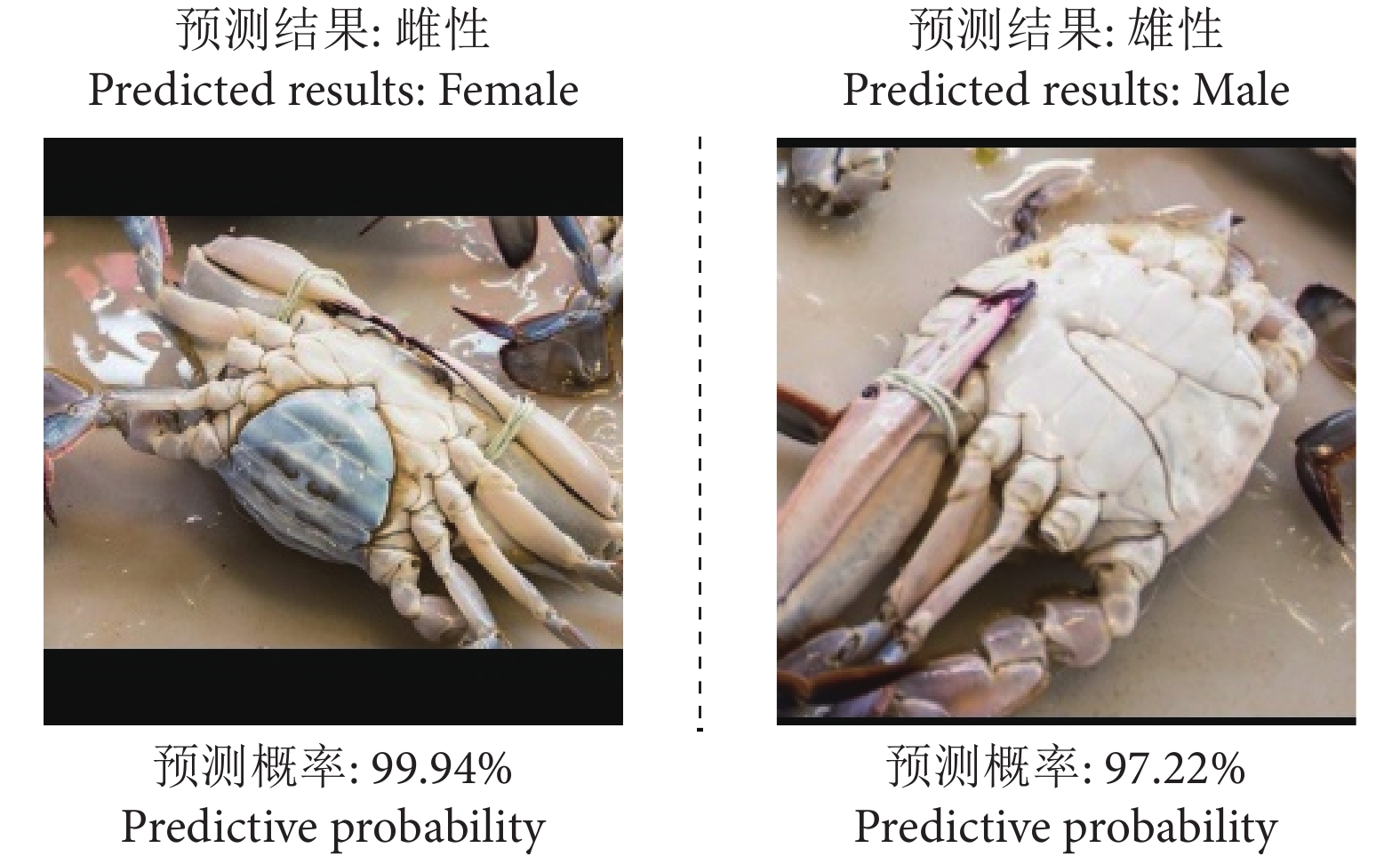

为了实现梭子蟹的智能化分拣,高精度的智能识别分类成为亟待开发的关键技术。首先对采集到的梭子蟹图像进行预处理和数据增强,构建出梭子蟹性别分类数据集 (Portunus gender classification dataset, PGCD);提出一种基于多组卷积神经网络的梭子蟹性别识别方法,该方法主要使用ResNet50从图像块中提取特征,降低特征提取过程的信息损失。为了更专注地找出输入数据的有用信息,开发出一种注意力机制来强调全局特征图中的细节重要性;最后进行了一系列的参数调整,提高了网络的训练效率和分类精度。实验结果显示,该方法在PGCD上的分类准确率、召回率和查准率分别达到95.59%、94.41%和96.68%,识别错误率仅为4.41%。表明该方法具有优越的分类性能,可用于梭子蟹性别的自动分类及识别系统。

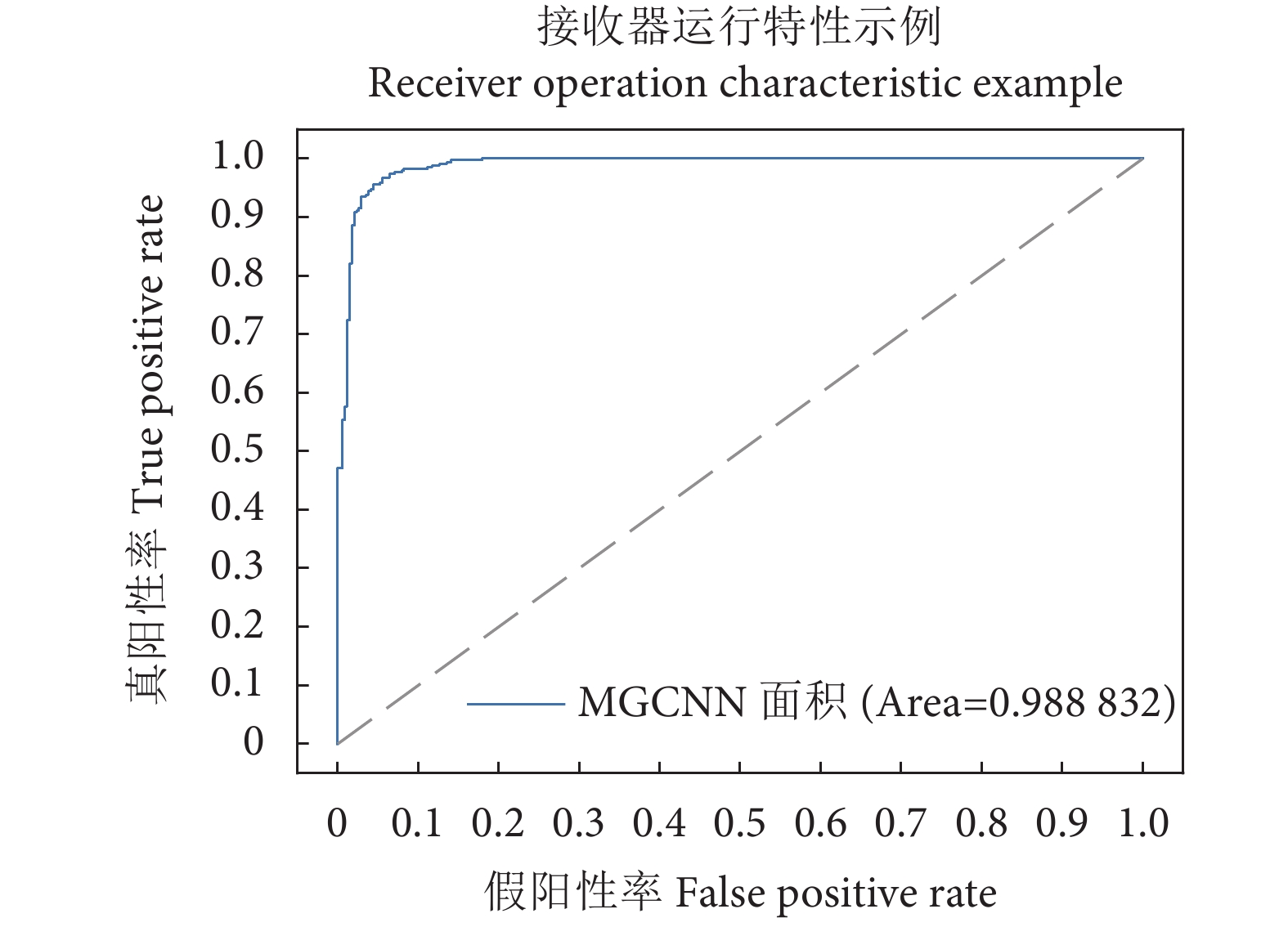

Abstract:High-precision intelligent recognition and classification has become a key technology for intelligent sorting of Portunus trituberculatus. We first preprocessed and enhanced the collected images of P. tritubereulatus so as to build a Portunus gender classification dataset (PGCD). Besides, we proposed a multi-group convolutional neural network for gender classification of P. tritubereulatus, mainly using ResNet50 to extract features from image patches, thereby reducing information loss during the feature extraction process. In order to focus more on finding useful information of input data, we also constructed an attention mechanism before gender classification to emphasize the importance of details in the global feature map. The results show that the classification accuracy, recall and accuracy of this method on PGCD were 95.59%, 94.41% and 96.68%, respectively, with a recognition error rate of only 4.41%. It is concluded that the method has superior classification performance and can be used in automatic classification and recognition systems for Portunus gender.

-

奥尼罗非鱼(Oreochromis niloticus♀×O.aureus♂)是一种中小形鱼,为世界水产业重点科研培养的淡水养殖鱼类,被誉为未来动物性蛋白质的主要来源之一,在日本被称为“不需要蛋白质的蛋白源”。罗非鱼肉质细嫩,味道鲜美,富含人体所需的8种必需氨基酸,其中甘氨酸和谷氨酸含量特别高[1-2]。

国内外关于罗非鱼营养方面的研究多集中在通过饲料试验研究营养对罗非鱼生长或生物学特征的影响等方面[3-5],但是对各种养殖模式罗非鱼肉品质的研究少见。笔者研究通过对池塘养殖和水库养殖罗非鱼的肌肉营养成分、感官特性、理化性质和游离氨基酸组成及含量进行分析与比较,探讨养殖模式对罗非鱼肉质的影响规律,为今后罗非鱼的健康、科学和高质养殖提供一定参考依据。

1. 材料与方法

1.1 材料

奥尼罗非鱼由佛山市某淡水养殖场提供,鱼体质量为(1 000±50)g。池塘养殖模式为罗非鱼与鲢(Hypophthalmichthys molitrix)、草鱼(Ctenopharyngodon idella)混养,定期投喂饲料,水深约1.5 m。水库养殖模式为网箱养殖,未投喂饲料,以浮游植物为食,水温常年在18~22 ℃,水深约50 m。

1.2 方法

鲜鱼覆冰保藏,及时送至实验室。取罗非鱼背部肌肉,先进行pH、质构、滴水损失、熟肉率、贮存损失及感官评定分析,剩余样品置于-18 ℃冷冻保存用于其余指标测定。

1.2.1 pH测定[6]

参考DUUN和RUSTAD[7]的方法,并稍加改动。称取碎鱼肉10 g,加入10 mL的0.15 mol·L-1氯化钾(KCl)溶液,用均质器13 000 r·min-1均质30 s,用pH计测定。

1.2.2 常规成分分析

水分测定采用恒温常压干燥法[8];粗蛋白测定采用凯氏定氮法[8];粗脂肪测定采用索氏提取法[8];灰分测定采用常压干燥法[8];总糖测定采用常规分析方法[9]。

1.2.3 肉质感官评定

取罗非鱼背部肌肉切成2 cm×2 cm×1 cm的块状,放入瓷碗里蒸煮8 min,邀请经过专业培训的9人同时参加品尝,采用“盲法”对罗非鱼的鲜味、口感、嫩度进行打分[10],以1~5之间的分值表示(表 1)。3项评分之和为该样品的可接受度值。

表 1 罗非鱼感官评定标准Table 1. Sensory evaluation standard for tilapia muscle指标 index 1分 2分 3分 4分 5分 鲜味 umami 滋味差,无鲜甜味 滋味较差,略带鲜甜味 滋味一般,有鲜甜味 滋味较好,鲜甜味较浓 滋味佳,鲜味浓 口感 mouthfeel 无弹性,口感差 略带弹性,口感较差 有弹性,口感一般 弹性较好,口感较好 弹性好,口感好 嫩度 tenderness 组织浮软 组织较松软 组织有一定弹性 嫩度较好 嫩度适中 1.2.4 熟肉率、蒸煮损失的测定[11]

取背部肌肉,切成1 cm×1 cm×1 cm的块状,放在蒸格上用沸水蒸8 min,取出后晾15 min,称质量并计算。

$$ {\rm{熟肉率}}(\% ){\rm{ = }}\frac{{\rm{蒸煮后肉样质量}}}{{\rm{蒸煮前肉样质量}}} \times {\rm{100}} $$ $$ \text { 蒸煮损失(%) = } 100 \text { - 熟肉率 } $$ 1.2.5 滴水损失[11]

取背肌切成3 cm×1 cm×1 cm小块,称质量后置于充气的塑料袋中(使肉块悬于中心不接触薄膜),在4 ℃冰箱中吊挂48 h后称质量,以样品质量损失百分比表示滴水损失。

$$ \text { 滴水损失 }(\%)=\frac{\text { 贮前质量 }- \text { 贮后质量 }}{\text { 贮前质量 }} \times 100 $$ 1.2.6 贮存损失测定

取背肌切成3 cm×1 cm×1 cm小块,装袋,在4 ℃冰箱中吊挂24 h后称质量并计算。

$$ \text { 贮存损失 }(\%)=\frac{\text { 贮前质量 }- \text { 贮后质量 }}{\text { 贮前质量 }} \times 100 $$ 1.2.7 肌内脂肪测定

参照郭焱芳[11]方法测定。取肉样绞成肉糜,取10 g置于广口瓶中,加入甲醇60 mL并盖好瓶盖,置于磁力搅拌器上搅拌30 min,加入三氯甲烷90 mL搅拌30 min,静置36 h。将浸提液过滤于刻度分液漏斗中,用约50 mL三氯甲烷分次洗涤残渣;加入30 mL蒸馏水,旋摇后静置待分层,上层为甲醇层,下层为三氯甲烷脂肪层,记录下层体积后缓慢打开分液漏斗弃去约2 mL后再缓慢放出下层液体于烧杯中,取4个已经干燥至恒质量的烧杯,用移液管移出50.00 mL下层液体于烧杯中烘干冷却,称质量并记录。

$$ \text { 肌内脂肪质量分数 }(\%)=\frac{\left(W_2-W_1\right) \times V_1}{W_0 \times 50} \times 100 $$ 其中W0为肉样质量(g);W1为烧杯质量(g);W2为烘干后烧杯和脂肪质量之和(g);V1为下层液体总体积(mL);50为下层液体取样量(mL)。

1.2.8 肌原纤维断裂指数(MFI)

测定参照雒莎莎等[12]和陆海霞[13]的方法并稍作修改。取2 g鱼肉加6倍体积的0.1 mol·L-1 KCl、0.02 mol·L-1三羟甲基氨基甲烷(Tris)-盐酸(HCl)(pH=7.5)缓冲液(A)和2倍体积的1% Triton、0.1 mol·L-1 KCl、0.02 mol·L-1 Tris-HCl缓冲液(B),匀浆,纱布过滤,去结缔组织,8 000 r·min-1冷冻离心10 min,去上清,沉淀用8倍体积的A液离心3次,最后用A液清洗沉淀稀释至20 mL,待测。将肌原纤维悬浮液蛋白质量浓度调整为(0.5±0.05)mg·mL-1,立即取10 mL在540 nm下测吸光度(OD),记为OD540 nm。

$$ \mathrm{MFI}=\mathrm{OD}_{540 \mathrm{~nm}} \times 200 $$ 1.2.9 肌红蛋白总量的测定

参照KRZYWICKI[14]方法,具体试验步骤见马汉军等[15]的方法。

1.2.10 游离氨基酸的测定

使用高效液相色谱仪进行分析[16]。

1.3 数据处理

所有数据采用统计软件SPSS 16.0进行分析处理。

2. 结果与分析

2.1 常规营养成分

2种模式养殖的罗非鱼肉粗脂肪、粗灰分质量分数分别为1.48%、0.74%,池塘养殖的总糖质量分数稍高于水库养殖,但两者均无显著差异(P>0.05)(表 2)。水库养殖的水分质量为湿质量的80.22%,显著高于池塘养殖的77.04%(P<0.05)。这是由于鱼体的水分质量分数和脂肪质量分数互成反比,水库养殖的粗蛋白质量分数(16.65%)和粗脂肪质量分数(1.37%)都低于池塘养殖(分别为18.82%和1.59%),故其水分质量分数相对较高。

表 2 罗非鱼肉常规营养成分比较(X±SD,n=3)Table 2. Nutritional components in muscle of different tilapia% 营养成分

nutritive composition池塘养殖

pond culture水库养殖

reservoir culture水分 moisture 77.04±0.08b 80.22±0.09a 粗蛋白 crude protein 18.82±0.12a 16.65±0.08b 粗脂肪 crude fat 1.59±0.24 1.37±0.15 粗灰分 crude ash 0.72±0.02 0.75±0.02 总糖 total sugar 0.12±0.06 0.06±0.02 注:同行不同字母表示差异显著(P<0.05),后表同此

Note:Means in the same row with different letter are significantly different (P<0.05), the same case in the following tables.2.2 感官评定

2种养殖模式罗非鱼肉的鲜味和口感值较接近,没有显著差异(P>0.05)(表 3)。水库养殖的嫩度和可接受度分别为4.87和14.30,显著高于池塘养殖的4.53和13.47(P<0.05)。

表 3 罗非鱼的感官评价分析(X±SD,n=9)Table 3. Muscle sensory evaluation of the different tilapia评定项目

assessment program池塘养殖

pond culture水库养殖

reservoir culture鲜味 umami 4.50±0.17 4.73±0.12 口感 mouthfeel 4.43±0.15 4.70±0.10 嫩度 tenderness 4.53±0.12b 4.87±0.12a 可接受度 acceptence 13.47±0.42b 14.30±0.26a 2.3 理化特性

表 4为不同养殖模式下罗非鱼肉质各项理化指标。2种养殖模式的熟肉率和蒸煮损失平均值分别为81.49%和18.51%,无显著差异(P>0.05)。池塘养殖的pH显著低于水库养殖(P<0.05);与池塘养殖相比,水库养殖的滴水损失和贮存损失分别高出1.85%和0.69%,差异显著(P<0.05);水库养殖的肌内脂肪比池塘养殖的高0.35%,差异显著(P<0.05);池塘养殖的MFI比水库养殖高38,差异显著(P<0.05)。肌红蛋白质量分数平均值为22.22 mg·kg-1,两者不存在显著差异(P>0.05)。

表 4 罗非鱼肉理化特性比较(X±SD,n=3)Table 4. Physi-chemical characters comparison of the different tilapia理化指标

physi-chemical index池塘养殖

pond culture水库养殖

reservoir culturepH 6.28±0.06b 6.43±0.09a 熟肉率/% rate of cooked meat 82.00±0.98 80.97±0.50 蒸煮损失/% cooking loss 18.00±0.98 19.03±0.50 滴水损失/% drip loss 7.75±0.41b 9.60±0.36a 贮存损失/% storage loss 3.20±0.34b 3.89±0.19a 肌内脂肪/% intramuscular fat 0.51±0.16b 0.86±0.19a 肌纤维断裂指数 myofibrillar fragmentation index(MFI) 161±4.58a 123±22.07b 肌红蛋白/mg·kg-1 myoglobin 20.25±0.69 24.19±2.58 2.4 氨基酸质量分数的分析

从罗非鱼肌肉中检测并鉴定了18种常见的氨基酸(表 5)。其中包括8种必需氨基酸,2种半必需氨基酸和8种非必需氨基酸。比较2种模式中各氨基酸的平均值发现,甘氨酸的质量分数均为最高,分别占其总氨基酸的46.40%(池塘养殖)和55.49%(水库养殖),池塘养殖模式中质量分数次之的是丙氨酸、苏氨酸、丝氨酸,水库养殖模式中质量分数次之的是苏氨酸、组氨酸、谷氨酸。两者间的天冬氨酸、谷氨酸、丝氨酸、甘氨酸、丙氨酸质量分数有显著差异(P<0.05),除此之外其他氨基酸不存在显著差异(P>0.05)。

表 5 罗非鱼肉中主要游离氨基酸组成及质量分数(湿质量)(X±SD,n=3)Table 5. Muscle main free amino acids contents of the different tilapia(wet weight)μg·g-1 游离氨基酸

free amino acid池塘养殖

pond culture水库养殖

reservoir culture天冬氨酸ae Asp 61.74±3.09a 11.73±3.88b 谷氨酸ae Glu 97.06±0.72a 82.73±2.94b 鲜味氨基酸总量(∑UAA) total umami amino acids 158.80±2.87a 94.46±5.96b 丝氨酸be Ser 120.23±5.51a 66.61±4.10b 甘氨酸be Gly 1 194.12±25.19a 1 189.80±16.91b 苏氨酸bc Thr 126.57±12.05 103.46±15.62 丙氨酸be Ala 347.81±18.67a 22.19±9.38b 脯氨酸be Pro 48.41±7.13 63.22±23.32 甜味氨基酸总量(∑SAA) total sweet amino acids 1 837.13±54.55a 1 445.29±58.54b 组氨酸d His 115.21±6.91 100.32±9.58 精氨酸d Arg 59.34±10.56 56.45±17.05 酪氨酸e Tyr 43.53±20.87 35.21±11.21 蛋氨酸c Met 41.85±8.76 34.10±8.41 色氨酸c Trp 43.73±9.58 79.72±26.10 苯丙氨酸c Phe 41.38±2.32 41.15±4.93 异亮氨酸c Ile 26.65±1.16 18.68±4.78 亮氨酸c Leu 47.31±3.05 42.80±7.02 赖氨酸c Lys 68.28±1.19 81.07±4.61 缬氨酸c Val 44.47±7.48 39.99±15.73 半胱氨酸e Cys 45.73±22.56 74.82±41.76 氨基酸总量(∑AA) total amino acids 2 573.41±104.36 2 144.05±99.19 必需氨基酸总量(∑EAA) total essential amino acids 440.24±15.61 440.97±25.31 半必需氨基酸总量(∑HEAA) total half-essential amino acids 174.54±17.28 156.76±26.04 ∑UAA/∑AA/% 6.17 4.41 ∑SAA/∑AA/% 71.39 67.41 ∑EAA/∑AA/% 17.11 20.57 ∑HEAA/∑AA/% 6.78 7.31 注:a.鲜味氨基酸;b.甜味氨基酸;c.必需氨基酸;d.半必需氨基酸;e.非必需氨基酸

Note:a. umami amino acids;b. sweet amino acids;c. essential amino acids;d. half-essential amino acids;e. not essential amino acids罗非鱼的鲜美程度取决于其蛋白质中鲜味氨基酸的组成和质量分数,天冬氨酸和谷氨酸为呈鲜味的特征氨基酸,其中谷氨酸的鲜味更强。谷氨酸不仅是呈鲜味氨基酸,还在人体代谢中具有重要意义,是脑组织生化代谢中首要的氨基酸,参与多种生理活性物质的合成,具有健脑作用[17]。在2种模式中,谷氨酸质量分数(μg·g-1,湿基)分别为97.06(池塘养殖)和82.73(水库养殖)。2种养殖模式的鲜味氨基酸总量(μg·g-1,湿基)分别为158.80(池塘养殖)和94.46(水库养殖),两者差异显著(P<0.05)。甜味氨基酸总量(μg·g-1,湿基)分别为1 837.13(池塘养殖)和1 445.29(水库养殖),分别占总氨基酸的71.39%(池塘养殖)和67.41%(水库养殖),前者明显高于后者(P<0.05)。必需氨基酸总量(μg·g-1,湿基)分别为440.24(池塘养殖)和440.97(水库养殖),两者相近(P>0.05)。组氨酸和精氨酸为半必需氨基酸,其总量(μg·g-1,湿基)分别为174.54(池塘养殖)和156.76(水库养殖)。精氨酸在人体饥饿、创伤或应激条件下会转变为必需氨基酸。

3. 讨论

1) 肌肉营养成分是评价养殖模式肌肉品质的重要指标。池塘养殖罗非鱼的粗蛋白质量分数较水库养殖的高,这可能与投喂的饲料有关。有关研究表明[18],饲料蛋白质量分数越高,鱼体内的粗蛋白质量分数也越高。从试验结果看出,池塘养殖饲料供给及时,营养充足,则鱼体的粗蛋白和粗脂肪质量分数相对较高。在粗灰分和总糖质量分数上,两者相差不大,说明罗非鱼肌肉粗灰分和总糖质量分数受其养殖环境的影响较小。

2) 一般认为,肉品风味随肌内脂肪的增加而改善。BEJERHOLM和BARTON-GADE[19]发现随着肌内脂肪质量分数的增加,嫩度也相应改善。笔者试验中水库养殖罗非鱼的肌内脂肪质量分数高于池塘养殖,与感官评定中的嫩度评分一致,同时,水库养殖的肌原纤维断裂指数比池塘养殖小,即水库养殖的嫩度较好,这3个指标的检测结果是一致的,因此可推测这三者之间存在着一定相关性。同时,pH是反映鱼体死后肌糖原酵解速率的重要指标,pH越低,说明酵解速度越快,pH缓慢降低可保持肉的嫩度。水库养殖的pH显著高于池塘养殖,即水库养殖的嫩度优于池塘养殖,这与前面的3个指标检测结果一致。

3) 滴水损失和持水力能够反映肉类保持其原有水分的能力。滴水损失与肌肉持水力呈负相关,滴水损失越低,肌肉持水力越好,鱼体死后失重小。从试验结果可知,水库养殖的滴水损失和贮存损失都比池塘养殖的高,说明池塘养殖的持水力高于水库养殖。熟肉率是衡量烹调损失的指标,具有重要的经济意义。试验结果表明池塘养殖的熟肉率高于水库养殖。

4) 从对罗非鱼肌肉的品质分析可以看出,尽管属于同一鱼种,但是不同养殖模式的罗非鱼在品质方面存在着一定的差别。有研究表明,鱼类肌肉品质的遗传变异很低[20],所以遗传变异的可能性不大。食物营养价值可以用多项指标来评价,蛋白质为重要的指标之一,尤其是氨基酸的组成及含量。这2种模式罗非鱼的蛋白质质量分数差异显著,其某些游离氨基酸的质量分数也存在显著差异。池塘养殖罗非鱼肌肉中谷氨酸的质量分数明显高于水库养殖,谷氨酸作为一种鲜味氨基酸,在脑组织生化代谢中具有重要作用,参与多种活性物质的合成。池塘养殖的呈味(鲜味和甜味)氨基酸质量分数都高于水库养殖,必需氨基酸总量虽相近,但氨基酸总量和半必需氨基酸总量均高于水库养殖。有研究表明,水产动物肌肉氨基酸组成与含量的不同,除了受到遗传因素的影响外,还与动物自身的生长发育、栖息环境、饵料种类与组成等密切相关[21-22]。此次采集的池塘养殖样品在养殖过程中定期投喂了饲料,而水库养殖样品主要以浮游植物为食,加上栖息环境的不同,因此造成了两者的差异。

从总体上看,水库养殖的罗非鱼嫩度要优于池塘养殖,但在营养成分及鲜甜味方面不及池塘养殖。

-

表 1 不同骨干模型对 MGCNN 性能的影响

Table 1 Effects of different backbone models on MGCNN performance

骨干模型

Backbone model准确率

Accuracy/%VGG VGG11 76.88 VGG13 82.59 VGG16 89.76 VGG19 86.09 ResNet ResNet18 90.44 ResNet34 91.15 ResNet50 92.79 ResNet101 92.21 ResNet152 88.24 表 2 不同优化器对MGCNN性能的影响

Table 2 Effects of different optimizers on MGCNN performance

骨干模型

Backbone model优化器

Optimizer准确率

Accuracy/%ResNet50 SGD 92.79 AdaGrad 89.56 RMSprop 95.15 Adam 95.29 Adamax 93.82 ASGD 92.65 表 3 不同参数对 MGCNN 性能的影响

Table 3 Effects of different parameters on MGCNN performance

学习率

Learning rate批大小

Batch size准确率

Accuracy/%0.000 1 32 92.94 0.000 5 95.00 0.001 0 95.29 0.001 5 95.59 0.002 0 92.65 0.001 5 64 94.56 32 95.59 16 95.15 表 4 MGCNN 与先进方法的比较

Table 4 Comparison between MGCNN and state-of-the-art methods

方法

Method准确率

Accuracy/%召回率

Recall/%查准率

Precision/%错误率

Error/%AlexNet 54.71 59.36 67.93 45.29 VGG16 89.85 88.24 91.19 10.15 ResNet152 94.56 94.71 94.43 5.44 DenseNet121 94.41 94.41 94.41 5.59 InceptionV3 95.00 92.65 97.22 5.00 MGCNN

(本研究方法 Our method)95.59 94.41 96.68 4.41 -

[1] 王陈星, 倪震宇, 刘必林, 等. 利用胃磨鉴定三疣梭子蟹年龄初探[J]. 南方水产科学, 2020, 16(3): 94-102. [2] DIXIT M, RASIWASIA N, VASCONCELOS N. Adapted gaussian models for image classification[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Colorado Springs, CO, USA. IEEE, 2011: 937-943.

[3] GAO Z H, LIU X W. Support vector machine and object-oriented classification for urban impervious surface extraction from satellite imagery[C]//The Third International Conference on Agro-Geoinformatics (ICAG), Beijing, China. IEEE, 2014: 1-5.

[4] GAN Z, ZHONG L, LI Y F, et al. A random forest based method for urban object classification using lidar data and aerial imagery[C]//The 23rd International Conference on Geoinformatics. Wuhan, China. IEEE, 2015: 1-4.

[5] MUNOZ D, BAGNELL J A, VANDAPEL N, et al. Contextual classification with functional max-margin markov networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Miami, FL, USA. IEEE, 2009: 975-982.

[6] NIEMEYER J, ROTTENSTEINER F, SOERGEL U. Contextual classification of lidar data and building object detection in urban areas[J]. Isprs J Photogramm, 2014, 87: 152-165. doi: 10.1016/j.isprsjprs.2013.11.001

[7] LECUN Y, BOTTOU L, BENGIO Y, et al. Gradient-based learning applied to document recognition[J]. P IEEE, 1998, 86(11): 2278-2324. doi: 10.1109/5.726791

[8] LECUN Y, BENGIO Y, HINTON G. Deep learning[J]. Nature, 2015, 521(7553): 436-444. doi: 10.1038/nature14539

[9] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. Imagenet classification with deep convolutional neural networks[J]. Commun Acm, 2017, 60(6): 84-90. doi: 10.1145/3065386

[10] SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[EB/OL]. (2015-04-10)[2022-02-26]. https://arxiv.org/abs/1409.1556.pdf.

[11] SZEGEDY C, LIU W, JIA Y Q, et al. Going deeper with convolutions[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Boston, MA, USA. IEEE, 2015: 1-9.

[12] HE K M, ZHANG X Y, REN S Q, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Las Vegas, NV, USA. IEEE, 2016: 770-778.

[13] HUANG G, LIU Z, MAATEN L V D, et al. Densely connected convolutional networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Honolulu, HI, USA. IEEE, 2017: 4700-4708.

[14] KRIZHEVSKY A, HINTON G. Learning multiple layers of features from tiny images[J]. Tech Rep, 2009(4): 1-80.

[15] RUSSAKOVSKY O, DENG J, SU H, et al. Imagenet large scale visual recognition challenge[J]. Int J Comput Vision, 2015, 115(3): 211-252. doi: 10.1007/s11263-015-0816-y

[16] 杜丽君, 唐玺璐, 周娇, 等. 基于注意力机制和多任务学习的阿尔茨海默症分类 [J]. 计算机科学, 2022, 49(S1): 60-65. [17] 王宁, 程家骅, 张寒野, 等. 水产养殖水体遥感动态监测及其应用 [J]. 中国水产科学, 2019, 26(5): 893-903. [18] 朱明, 张镇府, 黄凰, 等. 基于轻量级神经网络MobileNetV3-Small的鲈鱼摄食状态分类 [J]. 农业工程学报, 2021, 37(19): 165-172. [19] CAI J Y, LI C L, TAO X, et al. Image multi-inpainting via progressive generative adversarial networks[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), New Orleans, LA, USA. IEEE, 2022: 978-987.

[20] LIU F B, TIAN Y, CHEN Y H, et al. ACPL: anti-curriculum pseudo-labelling for semi-supervised medical image classification[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), New Orleans, LA, USA. IEEE, 2022: 20697-20706.

[21] MAITY A, ROY S G, BHATTACHARJEE S, et al. Prediction of Indian currency for visually impaired people using machine learning[M]. Singapore: Springer Nature Singapore, 2022: 263-275.

[22] YU H L, CHENG X H, CHEN C C, et al. Apple leaf disease recognition method with improved residual network[J]. Multimed Tools Appl, 2022, 81(6): 7759-7782. doi: 10.1007/s11042-022-11915-2

[23] WEI K M, LI T Q, HUANG F R, et al. Cancer classification with data augmentation based on generative adversarial networks[J]. Front Comput Sci, 2022, 16(2): 1-11.

[24] ZHAO Y, SHI Y B, WANG Z L. The improved YOLOV5 algorithm and its application in small target detection[C]//International Conference on Intelligent Robotics and Applications. Cham: Springer, 2022: 679-688.

[25] VASWANI A, SHAZEER N, PARMAR N, et al. Attention is all you need[J]. Adva Info Proces Sys, 2017, 30: 1-11.

[26] DOSOVITSKIY A, BEYER L, KOLESNIKOV A, et al. An image is worth 16×16 words: transformers for image recognition at scale [EB/OL]. (2021-06-03)[2022-02-26]. https://arxiv.org/pdf/2010.11929.pdf.

[27] HU Y Y, SUN S L, XU X, et al. Multi-view deep attention network for reinforcement learning (student abstract)[C]//Proceedings of the AAAI Conference on Artificial Intelligence (AAAI), New York, NY, USA. 2020, 34 (10): 13811-13812.

[28] WANG W J, WANG T, CAI Y. Multi-view attention-convolution pooling network for 3D point cloud classification[J]. Appl Intell, 2022, 52: 14787-14798.

[29] WANG W J, CAI Y, WANG T. Multi-view dual attention network for 3D object recognition[J]. Neural Comput Appl, 2022, 34(4): 3201-3212. doi: 10.1007/s00521-021-06588-1

[30] PASZKE A, GROSS S, MASSA F, et al. Pytorch: an imperative style, high-performance deep learning library[J]. Adva Informa Process, 2019, 32: 1-12.

[31] ZHANG Z J. Improved adam optimizer for deep neural networks[C]//IEEE/ACM 26th International Symposium on Quality of Service (IWQoS), Banff, AB, Canada. IEEE, 2018: 1-2.

[32] CEN F, ZHAO X Y, LI W Z, et al. Deep feature augmentation for occluded image classification[J]. Pattern Recogn, 2021, 10: 1-13.

[33] BIRD J J, BARNES C M, MANSO L J, et al. Fruit quality and defect image classification with conditional GAN data augmentation[J]. Sci Hortic, 2022, 10: 1-11.

[34] LANG H T, WU S W. Ship classification in moderate-resolution SAR image by naive geometric features-combined multiple kernel learning[J]. IEEE Geosci Remote S, 2017, 14(10): 1765-1769. doi: 10.1109/LGRS.2017.2734889

[35] ZHANG T W, ZHANG X L, KE X, et al. HOG-ShipCLSNet: a novel deep learning network with hog feature fusion for SAR ship classification[J]. IEEE T Geosci Remote, 2021, 60: 1-22.

[36] YU Q, YANG C Z, FAN H H, et al. Latent-MVCNN: 3D shape recognition using multiple views from pre-defined or random viewpoints[J]. Neural Process Lett, 2020, 52(1): 581-602. doi: 10.1007/s11063-020-10268-x

[37] ALAM M T, KUMAR V, KUMAR A. A multi-view convolutional neural network approach for image data classification[C]//International Conference on Communication information and Computing Technology (ICCICT), Online, IEEE, 2021: 1-6.

[38] YANG J, YANG G C. Modified convolutional neural network based on dropout and the stochastic gradient descent optimizer[J]. Algor, 2018, 11(3): 1-15.

[39] POOJARY R, PAI A. Comparative study of model optimization techniques in fine-tuned CNN models[C]//International Conference on Electrical and Computing Technologies and Applications (ICECTA), Ras Al Khaimah, United Arab Emirates. IEEE, 2019: 1-4.

[40] LYDIA A, FRANCIS S. AdaGrad: an optimizer for stochastic gradient descent[J]. Int J Inf Comput Sci, 2019, 6(5): 566-568.

[41] EOM S H. Developing sentimental analysis system based on various optimizer[J]. Internat J Intt, Broa Commun, 2021, 13(1): 100-106.

[42] RABBY S F, HASAN A, SOEB M J A, et al. Performance analysis of different convolutional neural network (CNN) models with optimizers in detecting tuberculosis (TB) from various chest X-ray images[J]. Euro J Enginee Tec Res, 2022, 7(4): 21-30. doi: 10.24018/ejeng.2022.7.4.2861

[43] SHI H Z, YANG N S, TANG H, et al. ASGD: sochastic gradient descent with adaptive batch size for every parameter[J]. Math, 2022, 10(6): 1-15.

[44] PAYMODE A S, MALODE V B. Transfer learning for multi-crop leaf disease image classification using convolutional neural network VGG[J]. Art Intell Agric, 2022, 6: 23-33.

[45] KHAN S, RAHMANI H, SHAH S A, et al. A guide to convolutional neural networks for computer vision[J]. Synth Lect Comput Vis, 2018, 8(1): 1-207.

[46] SZEGEDY C, VANHOUCKE V, IOFFE S, et al. Rethinking the inception architecture for computer vision[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Las Vegas, NV, USA. IEEE, 2016: 2818-2826.

-

期刊类型引用(1)

1. 薛尊,石建高,张文阳. 中国重力式深水网箱研究进展和展望. 渔业研究. 2024(04): 393-402 .  百度学术

百度学术

其他类型引用(1)

下载:

下载:

粤公网安备 44010502001741号

粤公网安备 44010502001741号